Kötü amaçlı kişiler, sahte haberler üretmek ve okuyucuları amaçları doğrultusunda kandırmak için giderek daha gelişmiş yöntemler kullanıyorlar. OpenAI’nin insan yazarlarını taklit etmeye çalışan GPT-2 modeli de dâhil olmak üzere AI (yapay zekâ) tabanlı metin üretme sistemleri bu konuda büyük rol oynuyor. Araştırmacılar, yapay olarak üretilen metni tespit etmek için araçlar geliştirmeye devam ediyorlar. Bununla birlikte MIT'den yeni bir araştırma, bu dedektörlerin çalışmasında temel bir kusur olabileceğini öne sürüyor.

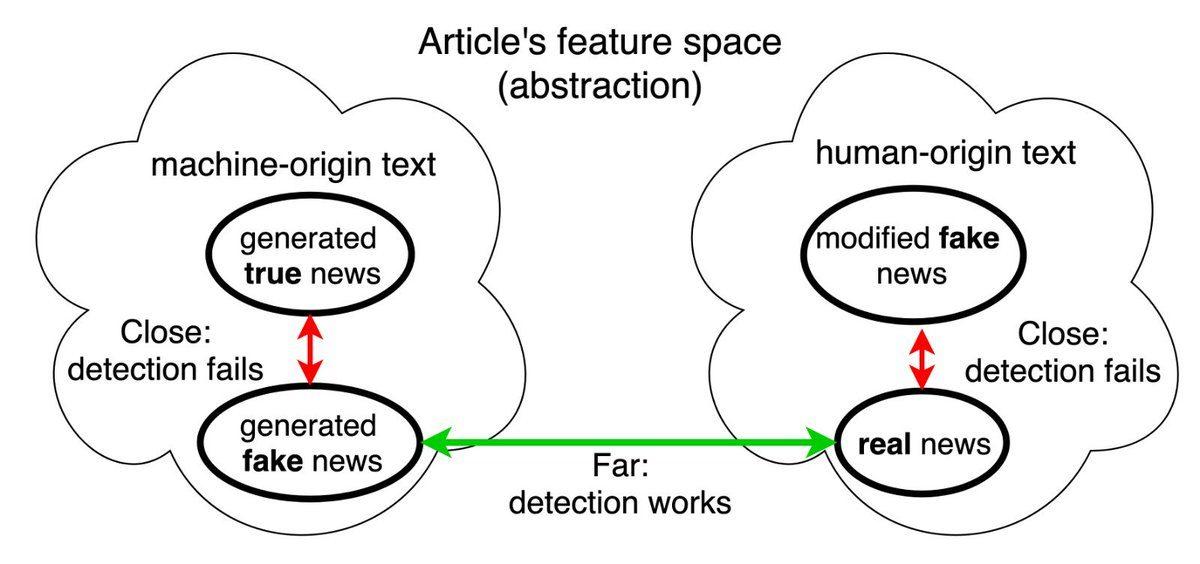

Geleneksel olarak bu araçlar, insanlar tarafından mı yoksa botlar tarafından mı yazıldığını belirlemek için bir metnin yazı stilini izler. İnsanlar tarafından yazılan metnin her zaman gerçek olduğunu ve botlar tarafından oluşturulan metnin her zaman sahte olduğunu varsayarlar. Bir makine, bazı kullanımlar için gerçek metin üretse bile bu algoritma tarafından sahte sayılır. Ayrıca araştırma, saldırganların insan tarafından üretilen metni manipüle etmek için araçlar kullanabileceğini vurgulamaktadır. Araştırmacılar, anlamını değiştirmek ve insan tarafından üretilen metni bozmak için GPT-2 modelini kullanmak üzere yapay zekâyı eğittiler.

Metnin bir makine tarafından mı yoksa bir insan tarafından mı üretildiğini belirlemek yerine bir metnin gerçek olup olmadığına bakılmalı:

MIT öğrencisi ve araştırmanın başyazarı olan Tal Schuster, bir makine mi yoksa bir insan tarafından mı üretildiğini belirlemek yerine bir metnin gerçek sahteciliğini tespit etmenin önemli olduğunu söyledi ve ekledi “Metnin makineler tarafından oluşturulup oluşturulmadığına bakılmaksızın içerikte 'sahte haberler' karakteristiğinin gerçekten sahtekârlık olduğunu düşünmemiz gerekir. Metin üreticileri belirli bir gündeme sahip değil. Bu teknolojinin nasıl kullanılacağına karar vermek kullanıcıya kalmış.”

MIT profesörü Regina Barzilay’a göre bu araştırma, mevcut haber sınıflandırıcılarının güvenilir olmadığını vurguluyor. Bu kusurların üstesinden gelmek için aynı araştırmacı grubu, dünyanın en büyük 'gerçekleri kontrol eden' veritabanı olan Fact Extraction And Verification'ı (FEVER) yeni tespit sistemleri geliştirmek için kullandı.

Araştırma ekibi, FEVER aracılığıyla geliştirilen modelin veri setinin önyargısı nedeniyle hatalara yatkın olduğunu tespit etti:

Schuster, olumsuz ifadelerin çoğu zaman model tarafından yanlış sayıldığını söyledi. İnsan tarafından oluşturulan ifadelerin çoğu ‘yapmadı’ ve ‘henüz’ şeklinde ve çoğunlukla yanlış ifadelerde görünüyor. Bununla birlikte takım, FEVER'i parçalayarak bir veri oluşturduğunda tespit modelinin doğruluğu %86'dan %58'e düştü. Modelin herhangi bir dış kanıt olmadan iddianın dilini dikkate aldığı söylendi. Dolayısıyla bir dedektörün gelecekteki bir olayı yanlış olarak kabul edebileceği bir ihtimal var çünkü dış kaynakları doğrulama sürecinin bir parçası olarak kullanmamış.

Ekip, durum kontrolünü mevcut savunma mekanizmalarıyla birleştirerek yeni yanlış bilgilendirme türlerini tespit etme modelini geliştirmeyi umuyor.

Paylaş

Paylaş

0

0

![[9-12 Ocak] 400 TL Değerindeki Oyun, Bu Hafta Sonu Steam'de Ücretsiz!](https://imgrosetta.webtekno.com/file/644092/644092-640xauto.jpg)